Ostatnio, przyduszona nieco nVidia, postanowiła wprowadzić do rozgrywki z ATI dwa „asy”. Są to „nowe” modele serii GeForce FX, oznaczone numerami 5500 i 5700 ULTRA GDDR 3. W mniemaniu firmy mają one ostro namieszać w niższym i średnim segmencie rynku. Jak jest naprawdę, przekonacie się czytając poniższy artykuł.

|

|

Na początek przyjrzyjmy się bliżej modelowi GeForce FX 5500, który docelowo przeznaczony jest na rynek tanich kart graficznych. Chipset ten jest zmodyfikowaną (czyt.: okrojoną) wersją modelu 5600. Taktowanie procesora wynosi tu 275 MHz (5600 – 325 MHz), pamięci taktowane są częstotliwością 400 MHz (5600 – 550 MHz), RAMDAC jest pojedynczy z zegarem 350 MHz (5600 – 2 x 400 MHz). Niezmieniona pozostała jedynie szyna pamięci, która w obu przypadkach wynosi 128 bitów. Pozostawiono także czteropotokową architekturę procesora. Obie karty z powodu przynależności do rodziny GeForce FX są oczywiście całkowicie zgodne ze standardem DirectX 9.

Zobaczmy teraz jak te „przeróbki” wpłynęły na wydajność karty. Na początek kilka podstawowych danych podawanych przez producenta. Wydajność Fillrate GeForce FX 5500 wynosi 1100 Megapixeli/s i 1100 Megatexeli/s, wobec, 1300 Megapixeli/s i 1300 Megatexeli/s GeForce'a FX 5600. Wydajność geometryczna to do 70 mln trójkątów/s, czyli o 10 mln mniej niż w przypadku 5600-tki. Spadła też przepustowość pamięci z 8,8 GB/s do 6,5 GB/s.

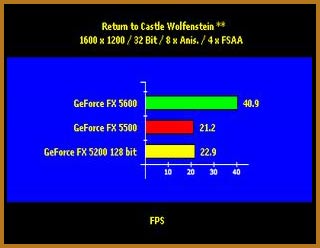

Po przestudiowaniu powyższych danych pewnie domyślacie się już, że w grach i benchmarkach nie ma co spodziewać się rewelacyjnych wyników, no przynajmniej w porównaniu z „protoplastą”. Ale zobaczmy. W 3D Marku 2003 w rozdzielczości 1024x768 w 32 bitowej głębi koloru, GeForce FX 5500 uzyskuje wynik 1606 punktów. Dla porównania wersja 5200 osiąga w tych warunkach, 1485 punktów czyli o 8 % mniej, a 5600-tka, 2537 punktów, więc aż o 57 % więcej. Jeśli podniesiemy "rozdziałkę" do 1600x1200 i dodamy ośmiokrotny anisotropic oraz czterokrotny Anti-Aliasing, to przewaga nad 5200-tką spada do 5%, a strata do 5600-tki rośnie do 65 %.W grze RETURN TO CASTLE WOLFENSTEIN w standardowych ustawieniach przy podziałce 1024x768, 5500-tka wyciąga 130.5 klatki na sekundę, 5200-tka 136.5 ( 4,5 % więcej ), a 5600-tka 149,7 ( 15 % więcej ). Po ustawieniu rozdziałki na 1600x1200 i włączeniu bajerów ( 8x Anis. i 4x FSAA ) powtarza się sytuacja z 3D Marka, czyli wydajność GeForce FX 5500 spada zarówno względem 5200-tki jak i 5600-tki, odpowiednio o 8 % i 93% !!!

Zobaczmy teraz jak przedstawiają się ceny kart. GeForce FX 5500 kosztuje około 425 PLN *, GeForce FX 5200 128 bit około 375 PLN *, a GeForce FX 5600 około 550 PLN *. Jak widać 5200-tka jest ponad 13 % tańsza od 5500-tki a w większości testów jest szybsza, natomiast 5600-tka jest droższa o około 30 % ale w każdym teście jest znacznie bardziej wydajna. Jednak wybór karty pozostawiam oczywiście Wam, drodzy czytelnicy.

Drugim „asem” w talii nVidii ma być GeForce FX 5700 ULTRA GDDR 3. Nie byłoby w tej karcie nic nadzwyczajnego gdyby nie fakt, że na pokładzie ma ona pamięci SAMSUNGA w standardzie

GDDR3. Co to oznacza w praktyce? A no to, że zamiast pamiątek DDR2 zastosowano GDDR3.

Nowe pamięci mają obniżoną wartość napięcia z 2,5 V do 1,8 V co powinno znacznie obniżyć temperaturę podczas pracy, a co za tym idzie ułatwić podkręcanie pamięci na karcie. Jeśli już o podkręcaniu mowa to GDDR3 standardowo montowane na kartach GeForce FX 5700 ULTRA GDDR 3 (zegar rdzenia pozostał bez zmian - 475 MHz) są taktowane rzeczywistym zegarem 475 MHz co w trybie DDR daje efektywne 950 MHz, dla przypomnienia „zwykłe” GeForce FX 5700 ULTRA mają pamięci DDR2 o rzeczywistym taktowaniu 450 MHz (efektywne 900 MHz), według producenta dają się, przy zastosowaniu odpowiedniego chłodzenia oczywiście, podkręcić do co najmniej 625 MHz (1250 MHz).

No cóż, jeśli okazałoby się to prawdą byłby to wynik całkiem niezły, żeby nie powiedzieć bardzo dobry, ale niestety nie zostało to jeszcze przez nikogo sprawdzone w praktyce ;). Gwoli informacji dodam jeszcze, że SAMSUNG zapowiada rychłą produkcję kości taktowanych rzeczywistym zegarem 800 MHz, co daje niebagatelne 1,6 GHz efektywnego zegara pamięci. OK, pora zejść na ziemię i zajrzeć do testów „zwykłego” GeForce FX 5700 ULTRA GDDR 3 wyposażonego w standardowe pamięci GDDR3.

|

W grze Unreal Tournament 2004

przy normalnych ustawieniach w rozdzielczości 1024x768 i 32 bitowej palecie kolorów karta oparta o pamięci GDDR3 uzyskuje wynik 75.2 klatki na sekundę a więc w zasadzie taki sam jak Forsiak z pamięciami DDR2. Dla porównania GeForce FX 5900 XT uzyskuje wynik 94.9 klatek, a Radon 9600 XT wyciąga 76.4 klatki. Jeśli podnieść rozdziałkę na 1600x1200 to sytuacja przedstawia się podobnie, tylko GeForce FX 5900 TX wyraźnie prowadzi bo aż o 42%, a pozostałe karty uzyskują prawie identyczny wynik. Tyle, że GeForce FX 5700 ULTRA GDDR 3, jest minimalnie wolniejszy od swego starszego brata, ale za to nieco szybszy od Radka 9600 XT.

W CALL OF DUTY natomiast Forsiak na GDDR3 w trybie 1600x1200x32 bity uzyskuje dokładnie taki sam wynik jak wersja z DDR2, a mianowicie 48.5 klatki na sekundę. Okazuje się natomiast o ponad 18% wydajniejszy od Radeona 9600 XT i o prawie 15 % słabszy do GeForce FX 5900 XT.

GeForce FX 5700 ULTRA i GeForce FX 5700 ULTRA GDDR3 – bliźniacy ??? jedno czy dwu jajowi ???

Na koniec zobaczmy jak nasi zawodnicy poradzą sobie z demem COLIN MCRAE 4. W rozdziałce 1280x1024 i 32 bitowym kolorze, bez włączonych bajerów, GeForce FX 5700 ULTRA GDDR 3 plasuje się na przedostatnim miejscu wyprzedzając nieznacznie wersje DDR2, bo tylko o niecałe 2%. Do Radeona 9600 XT traci już prawie 20 % a do GeForce FX 5900 XT ponad 37 %. Po podniesieniu rozdzielczości obrazu do 1600x1200 sytuacja przedstawia się podobnie.

WinFast GeFprce FX 5500-8X

Podsumowując o ile pierwsza opisywana karta, a mianowicie GeForce FX 5500 okazuje się całkowitym niewypałem: kiepskie osiągi i relatywnie wysoka cena, to w przypadku GeForce FX 5700 ULTRA GDDR 3 trudno jest o tak jednoznaczną ocenę. Karta na standardowych ustawieniach uzyskuje prawie identyczne wyniki jak jej starszy model oparty na pamięciach DDR2, w pewnych aplikacjach z kolei jest wydajniejsza od Radeona 9600 XT, w innych zaś uzyskuje wyniki gorsze. W każdym zaś przypadku jest znacznie słabsza od GeForce FX 5900 XT. Jeśli wierzyć zapewnieniom SAMSUNGA, że ich nowe pamięci dają się tak wyśmienicie podkręcać i zapewnieniom nVIDII, że karta ma być tańsza od dotychczasowych modeli z serii GeForce FX 5700 ULTRA, może się ona okazać dość ciekawą propozycją dla średnio zamożnych klientów. Jak na razie jednak najlepszą propozycją w tym segmencie wydaje się być GeForce 5900 XT za około 949 PLN *.

Ładny kotlecik, tylko szkoda że odgrzewany :(

* ceny orientacyjne z kwietnia 2004 roku

** wszystkie testy wykonane na komputerze z procesorem Intel Pentium IV 3,2 GHz HT, wyposażonym w 1024 MB RAM DDR, w środowisku Windows XP Prof. SP1a, DirectX 9.0b

PS. Wielkie tnx dla kolegi Rem'X’a za korektę.

|

|

|

|